突然気胸で二週間入院することになったのでEMNLP2022の採択論文を眺めた話

暇だったので。

Contents

- 1 まとめ

- 2 概要

-

3 採択論文の眺め方

- 3.1 EMNLP2022で気になった論文一覧

- 3.2 ワードクラウドで遊ぶ

-

3.3 論文メモ

- 3.3.1 RetroMAE: Pre-Training Retrieval-oriented Language Models Via Masked Auto-Encoder.

- 3.3.2 Zero-Shot Text Classification with Self-Training.

- 3.3.3 How Far are We from Robust Long Abstractive Summarization?

- 3.3.4 Invariant Language Modeling.

- 3.3.5 CTRLSUM: Towards Generic Controllable Text Summarization.

- 3.3.6 A Survey of Active Learning for Natural Language Processing.

- 3.3.7 Revisiting Grammatical Error Correction Evaluation and Beyond.

- 3.3.8 X-FACTOR: A Cross-metric Evaluation of Factual Correctness in Abstractive Summarization.

- 3.3.9 PromptBERT: Improving BERT Sentence Embeddings with Prompts.

- 3.3.10 Automatic Document Selection for Efficient Encoder Pretraining.

- 3.3.11 Large Dual Encoders Are Generalizable Retrievers.

- 3.3.12 Improving Iterative Text Revision by Learning Where to Edit from Other Revision Tasks.

- 4 論文を読んだ感想

まとめ

- 気胸で入院することで828件のタイトルを眺め、最終的に28件の論文を読んだ

- 個人的にめちゃくちゃ面白かった論文は多分こちら

- Invariant Language Modeling.

- PromptBERT: Improving BERT Sentence Embeddings with Prompts.

- Automatic Document Selection for Efficient Encoder Pretraining.

- トホホ、気胸はもうこりごりだよぉ~

概要

以前の投稿でも触れましたが、1月末から二週間ほど気胸で入院していました。。。

自分の場合、病院受診、緊急搬送、即入院の流れだったので、手元にスマホしかない状況でした。

あまりにも暇かつ、何もしていないと思考が悪い方向に進んでいくので、現実逃避も兼ねてEMNLP2022の採択論文を眺めた次第です。

採択論文の眺め方

今回の場合、時間に余裕があるので本会議採択論文828件のタイトルを眺めて、その中から気になったものをちゃんと読む形をとりました。

具体的には次の工程です。

- EMNLP2022採択論文828件のタイトルを全て眺めて、気になったものを残す

- 1の各論文のアブストラクトを眺めて、気になったものを残す

- 2で残った論文を(程度は様々に)読む

タイトル、アブストラクトの順で篩にかける形ですね。

大体1の工程で1/10程度になって、2で1/5程度になる印象です。

ちなみに3番まで進んだ論文は必ずintroductionは読んで、面白かったら精読するし、ちょっと気になるぐらいなら斜め読み、なんか違うかなとなったらそこで読むのを止めてます。

今回は実際に3番まで進んだ論文一覧をメモとして列挙します。

(解説とかではないです。)

EMNLP2022で気になった論文一覧

気になった論文は次の28件です。

The Geometry of Multilingual Language Model Representations.

Toward Unifying Text Segmentation and Long Document Summarization.

SNAC: Coherence Error Detection for Narrative Summarization.

RetroMAE: Pre-Training Retrieval-oriented Language Models Via Masked Auto-Encoder.

Zero-Shot Text Classification with Self-Training.

Efficient Nearest Neighbor Search for Cross-Encoder Models using Matrix Factorization.

How Far are We from Robust Long Abstractive Summarization?

Summarizing Community-based Question-Answer Pairs.

Sparse Teachers Can Be Dense with Knowledge.

DuReaderretrieval: A Large-scale Chinese Benchmark for Passage Retrieval from Web Search Engine.

Invariant Language Modeling.

CTRLSUM: Towards Generic Controllable Text Summarization.

A Survey of Active Learning for Natural Language Processing.

Bernice: A Multilingual Pre-trained Encoder for Twitter.

Revisiting Grammatical Error Correction Evaluation and Beyond.

X-FACTOR: A Cross-metric Evaluation of Factual Correctness in Abstractive Summarization.

HashFormers: Towards Vocabulary-independent Pre-trained Transformers.

Decoding a Neural Retriever’s Latent Space for Query Suggestion.

PromptBERT: Improving BERT Sentence Embeddings with Prompts.

Incorporating Relevance Feedback for Information-Seeking Retrieval using Few-Shot Document Re-Ranking.

Few-shot Learning with Multilingual Generative Language Models.

Automatic Document Selection for Efficient Encoder Pretraining.

Large Dual Encoders Are Generalizable Retrievers.

Improving Iterative Text Revision by Learning Where to Edit from Other Revision Tasks.

Mask the Correct Tokens: An Embarrassingly Simple Approach for Error Correction.

CODER: An efficient framework for improving retrieval through COntextual Document Embedding Reranking.

CiteSum: Citation Text-guided Scientific Extreme Summarization and Domain Adaptation with Limited Supervision.

Pseudo-Relevance for Enhancing Document Representation.ワードクラウドで遊ぶ

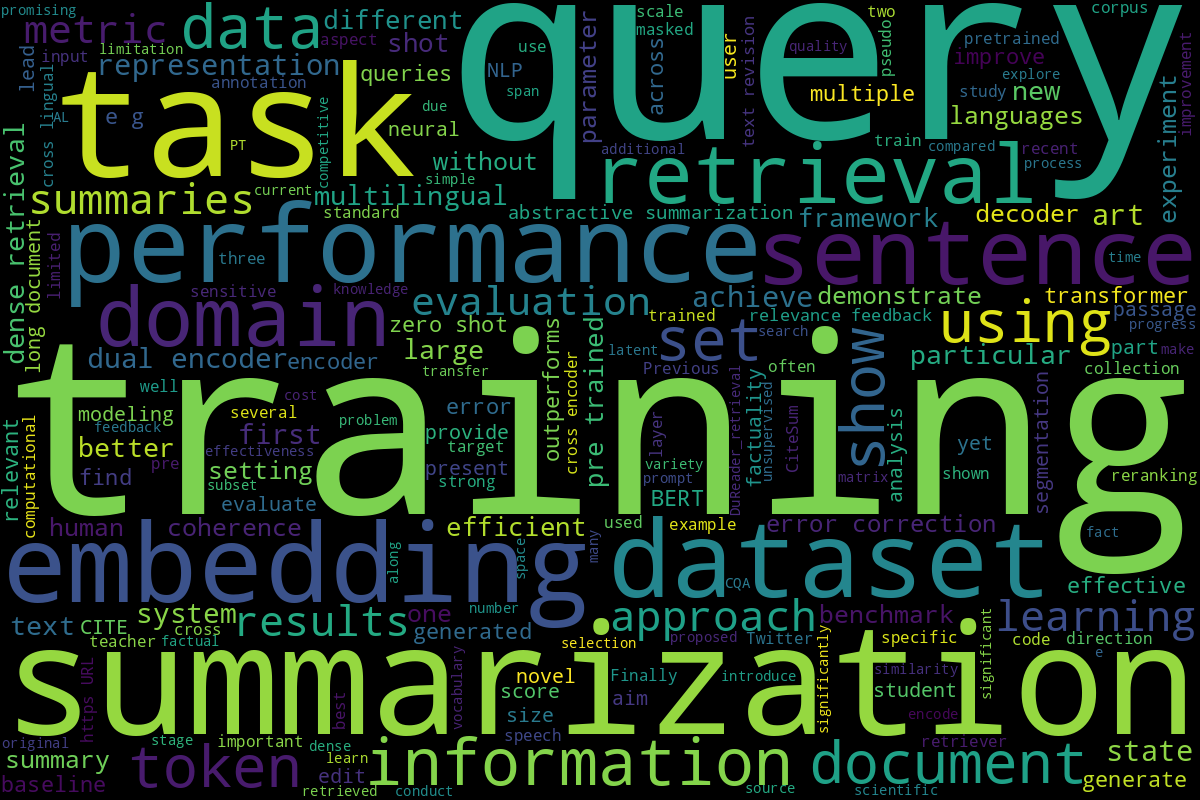

せっかくなので、読んだ論文28件のアブストラクトをワードクラウドに入れてみました。

(ストップワードは適当に設定しています。)

特徴的な単語としては「query」、「retrieval」、「embedding」、「summarization」とかでしょうか。

そうでしょうね的な感想しかでないです。。。

論文メモ

28件の論文のうち、特に気になる論文のメモを残しておきます。

(解説とかではないので、内容が気になった場合は元論文に当たってください。)

RetroMAE: Pre-Training Retrieval-oriented Language Models Via Masked Auto-Encoder.

https://aclanthology.org/2022.emnlp-main.35/

Retrieval系のお話です。

検索用の分散表現作成を目的として、MAE (Masked Auto-Encoder) を利用した事前学習を行った論文です。

MAEはreconstructionをやってて、それがめちゃくちゃ効いた的な話みたいです。

Fig.1が概要図になってます。

Zero-Shot Text Classification with Self-Training.

https://aclanthology.org/2022.emnlp-main.73/

Zero-Shot分類でNLIベースのものが既存研究であって、それにself-trainingを足した話です。

手法としては素直なんですが、結果がけっこう上がっていてちょっと驚きました。

How Far are We from Robust Long Abstractive Summarization?

https://aclanthology.org/2022.emnlp-main.172/

最近流行り?のLong Text SummarizationについてBART、PEGASUSベースのモデルのベースライン調査を行ってます。

また、relevanceとfactual consistencyについて、人手と自動評価の相関を測定してます。

特にこのメタ評価の話(Table 3)は勉強になりました。

Invariant Language Modeling.

https://aclanthology.org/2022.emnlp-main.387/

Invariant Risk Minimization (IRM)をBERTの事前学習で実施することで、invariant性を満たすような実験結果が確認できた的な話です。

やりたいことはFig. 1の通りで、それを実現する学習の流れがAppendix A.のFig. 3に記載されています。

もう少し語ると、学習データのenvironments(だいたいドメイン)間でのinvariant relationshipを学習しよう、みたいな話がcausal inferenceではよくあるので、それをBERTでやった話、のはずです。

各enviromentのfeatureをinvariantなものと、spurious、つまりenvironments間で一般化できないものに分けて考えて、前者を素性抽出できるモデル(BERTなど)を作成することを頑張った話だと思います。

このモデル作成は、IRMおよびIRM-gamesを参考にして行うのですが、この部分がすごくシンプルな構造になっています(Alg. 1)。

検証としては

- robustness to noise

- bias removal

- out-of-domain generalization

を行っていて、それぞれで有効であることを報告しています。

また、Sec. 5.2では提案手法が表層的な話ではなく、潜在空間の話であることを強調するために、environmentとしてmultilingual(EnglishとFarsi)で実験した話も掲載されています。

EMNLP2022の中で個人的にこの論文が一番面白く、勉強になったのですが、うまく言語化できていない感があります。。。

CTRLSUM: Towards Generic Controllable Text Summarization.

https://aclanthology.org/2022.emnlp-main.396/

要約の出力制御は大抵モデル構造、出力構造で頑張ることが多い(と思っている)のですが、

この研究ではキーワード(Prompt)で出力制御を行うことを目指しています。

入出力の例はTab. 1にあります。

夢があるなーとか思いながら読んでいました。

A Survey of Active Learning for Natural Language Processing.

https://aclanthology.org/2022.emnlp-main.414/

タイトルの通りです。

現在のActive Learningの主要な研究トピックがまとまっています。

Active LearningをAlg. 1にまとめていて、その構成要素を各章で解説する形を取っています。

基本的にアノテーションするサンプルを選択する研究について書いてあります。

Revisiting Grammatical Error Correction Evaluation and Beyond.

https://aclanthology.org/2022.emnlp-main.463/

GECの自動評価尺度はm2、ERRANTと呼ばれる編集部分の一致を確認する方法、またはGLEUと呼ばれるBLEUのような方法が(少なくとも自分が研究していたときは)よく使われています。

この論文では、編集部分の一致を取りつつ、BERTScoreの手法を混ぜた自動評価尺度を提案しています。

X-FACTOR: A Cross-metric Evaluation of Factual Correctness in Abstractive Summarization.

https://aclanthology.org/2022.emnlp-main.478/

factuality改善に関する要約に関する論文です。

factuality-awareな要約モデルを調査した後、3.7章で自動評価尺度間の相関を、3.8章で人手相関を報告しています。

特に3.7章は面白く、Tab. 5に記載されているROUGEと各種factuality評価尺度の相関は勉強になりました。

「How Far are We from Robust Long Abstractive Summarization?」もそうですが、factualityは要約において重要な要素だと思うので、もうしばらく追っていきたいですね。

PromptBERT: Improving BERT Sentence Embeddings with Prompts.

https://aclanthology.org/2022.emnlp-main.603/

特になんの工夫もなくBERTの出力ベクトルをそのまま類似度算出などに使用するとうまくいかないことが往々にしてあります。

この現象の理由として、BERTのベクトル空間がanisotropicで、narrow coneな埋め込みになっているから(SimCSEなど)だと言われています。

(ちなみにnarrow coneの話はこの論文が詳しいです。昔研究室で論文紹介したスライドがこちら。)

この論文では、BERTが出力する分散表現がうまく働かない原因として、anistropicというより、BERTのlayerが効果的に機能していないのと、0-layer(つまりstatic embedding)のbiasが影響していると主張しています。

詳しくはSec. 3に記載されています。

実際、2つめのbiasに関する調査として、Fig. 1に図示した例が載っていますが、たしかに頻度、case/uncase、subwordで分かれているのがわかります。

この対応として、Promptingをベースとした文分散表現作成を提案しています。

[MASK]トークンを利用して分散表現を作成することで、問題となったbiasも軽減され、MLMの事前学習で[MASK]トークンのhiddenならばBERTのlayerも機能する、と言った具合のようです。

詳しくはSec. 4に記載されています。

確かにこの方法(といくつかの工夫)でSimCSEといった手法と比べて高い精度となっていて、ちょっとおもしろいと思いました。

Automatic Document Selection for Efficient Encoder Pretraining.

https://aclanthology.org/2022.emnlp-main.647/

データ選択手法と聞いて何を思い浮かべますか?

自分はMoore and Lewis. [link]がシンプルかつ動かしやすくて好きです。

この論文では、Cynical Data Selection [link]を利用してデータ選択を行います。

具体的には、BERTの事前学習に使用するデータのためにこの手法を用いています。

in-domainなBERTを作成する際に、そのドメインのデータだけでなく、一般ドメインのデータからそのドメインに関連するデータを選択し、事前学習に使用します。

このように関連するデータを使用することで、効率的にin-domainのモデルを作成することが期待されます。

恥ずかしながら、Cynical Data Selectionを知らなかったので勉強になりました。

Large Dual Encoders Are Generalizable Retrievers.

https://aclanthology.org/2022.emnlp-main.669/

パラメータ数がすごく大きいDual EncoderはBM25やColBERTより高い精度になることを実験的に示した論文です。

評価はMS MarcoやBM25で行っていて、Fig 1.やTab. 3に実験結果が載っています。

他にも、分析などが報告されていて勉強になりました。

Improving Iterative Text Revision by Learning Where to Edit from Other Revision Tasks.

https://aclanthology.org/2022.emnlp-main.678/

Grammarly Paperです。

Revisionして欲しい文章が与えられたら、自動でintent edit span(単語ごとにfluencyのeditが必要、coherenceのeditが必要といったもの)を推定し、その結果を別途Revisionモデルに投げて修正を行います(Fig. 1が概要図です。)。

これをIterativeに行うことで、Revisionを実施しています。

文章の修正は以前から興味があり、すごく勉強になりました。

論文を読んだ感想

論文は適度に頭を使いながら読めるので、夢中になって読むことができました。

ただ、正直なところ、手術前日とかはあまり集中して論文読めなかったです。

逆に手術数時間前は結構ちゃんと読めました。現実逃避したかったんだとおもいます。